Материалы по тегу: pci express 5.0

|

08.04.2024 [09:48], Сергей Карасёв

CXL из коробки: Samsung представила стоечный массив памяти CMM-BКомпания Samsung анонсировала решение под названием CXL Memory Module — Box (CMM-B): это массив модулей памяти CXL, предназначенный для монтажа в стойку. Новинка совместима с решениями Supermicro Plug and Play. В состав CMM-B входят восемь пулов CXL-памяти на базе модулей E3.S CMM-D (PCIe 5.0) ёмкостью 2 Тбайт каждый. Таким образом, суммарный объём достигает 16 Тбайт. В составе стойки доступ к этому массиву могут получать три сервера Supermicro. Такая архитектура позволяет выделять необходимый объём памяти в соответствии с текущими нагрузками, устраняя узкие места в вычислительных системах. Через консоль SCMC (Samsung Cognos Management Console) можно отслеживать распределение памяти.

Источник изображений: Samsung Устройство CMM-B выполнено в формате 4U. Заявлена совместимость со стандартами CXL 1.1/2.0. Пропускная способность достигает 60 Гбайт/с, тогда как задержка находится на уровне 596 нс. С точки зрения «чистой» производительности один модуль CMM-B работает медленнее, чем двухканальная подсистема оперативной памяти DDR5-4800. Тем не менее, устройство значительно быстрее, чем даже наиболее передовые SSD.  Представленная стоечная система разработана в тесном сотрудничестве с Supermicro. В состав решения, помимо CMM-B и трёх серверов, входит PCIe-коммутатор. Система предназначена для приложений, которым требуется большой объём памяти, таких как ИИ, анализ массивов информации и in-memory базы данных. CMM-B позволяет динамически выделять необходимую память системе, когда она необходима ей. Благодаря этому повышается гибкость использования инфраструктуры и снижаются энергетические затраты, говорят создатели.

29.03.2024 [13:39], Сергей Карасёв

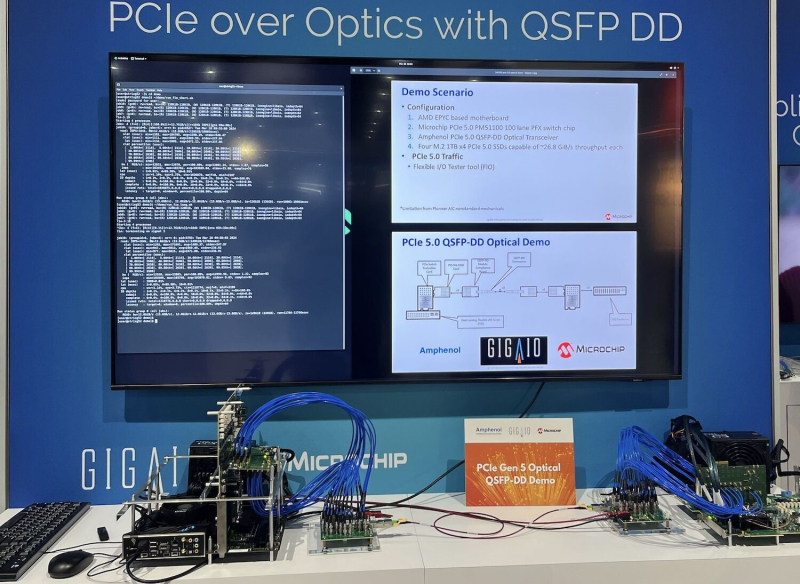

GigaIO представила оптические кабели PCIe 5.0 для развёртывания масштабных ИИ-кластеровКомпания GigaIO, разрабатывающая систему распределённого интерконнекта на базе PCI Express под названием FabreX, представила первые в отрасли оптические кабели QSFP-DD с поддержкой PCIe 5.0. Отмечается, что оптические кабели обеспечивают ряд преимуществ перед традиционными медными соединениями. Это, в частности, повышенная пропускная способность. Кроме того, длина оптических линий может превышать 3 м, что является ограничением для медных кабелей. Представленные кабели используют конфигурацию PCIe 5.0 x8 с возможностью агрегации 16 линий. Благодаря этим изделиям упрощается развёртывание высокопроизводительных систем GigaIO SuperNODE, которые позволяют связать воедино до 32 ускорителей посредством упомянутой платформы FabreX. Отмечается, что оптические кабели способны обеспечить передачу данных с высокой скоростью на десятки метров. Таким образом, несколько систем SuperNODE или SuperDuperNODE могут быть объединены в единый кластер для решения наиболее ресурсоёмких задач ИИ. Медные соединения обычно ограничивают размер кластеров двумя–тремя стойками. В случае оптических кабелей предоставляется гораздо большая гибкость в плане конфигурации оборудования. В результате системы SuperNODE могут быть развёрнуты даже в тех дата-центрах, в которых существуют жёсткие ограничения по мощности и охлаждению в расчёте на стойку. Оптические кабели QSFP-DD с поддержкой PCIe 5.0 станут доступны предстоящим летом.

24.03.2024 [02:19], Сергей Карасёв

WEKApod для SuperPOD: WekaIO представила платформу хранения данных для ИИ-кластеров NVIDIAКомпания WekaIO, разработчик решений для хранения данных, анонсировала высокопроизводительное All-Flash хранилище WEKApod, оптимизированное для работы с платформой NVIDIA DGX SuperPOD на базе NVIDIA DGX H100. Новинка объединяет специализированное ПО WekaIO и «лучшее в своем классе оборудование». Хранилище WEKApod спроектировано для ресурсоёмких нагрузок ИИ. Базовая конфигурация состоит из восьми 1U-узлов, обеспечивающих суммарную вместимость в 1 Пбайт. Показатель IOPS (операций ввода-вывода в секунду) достигает 18,3 млн. Заявленная пропускная способность при чтении составляет до 720 Гбайт/с, при записи — до 186 Гбайт/с. Утверждается, что восемь узлов WEKApod обеспечивает производительность, необходимую для 128 систем NVIDIA DGX H100. При этом WEKApod может масштабироваться до сотен узлов блоками по четыре узла. Таким образом, можно сформировать систему необходимой вместимости с высокой отказоустойчивостью для обучения больших языковых моделей (LLM), ИИ-приложений, работающих в реальном времени, и пр.

Источник изображения: WekaIO Отмечается, что архитектура WEKApod обеспечивает снижение энергопотребления благодаря оптимальному использованию пространства, улучшенному охлаждению и средствам энергосбережения в режиме простоя. В результате, достигается потенциальное сокращение углеродного следа до 260 т/Пбайт. WEKApod использует адаптеры NVIDIA ConnectX-7 и NVIDIA Base Command Manager для мониторинга и управления. Каждый из узлов несёт на борту процессор AMD EPYC 9454P (48C/96T; 2,75–3,80 ГГц; 290 Вт) и 384 Гбайт памяти DDR5-4800. Есть посадочные места для 14 накопителей формата E3.S с интерфейсом PCIe 5.0. Производительность в расчёте на узел достигает 90 Гбайт/с при чтении и 23,3 Гбайт/с при записи, а величина IOPS равна 2,3 млн при произвольном чтении и 535 тыс. при произвольной записи.

14.03.2024 [10:03], Сергей Карасёв

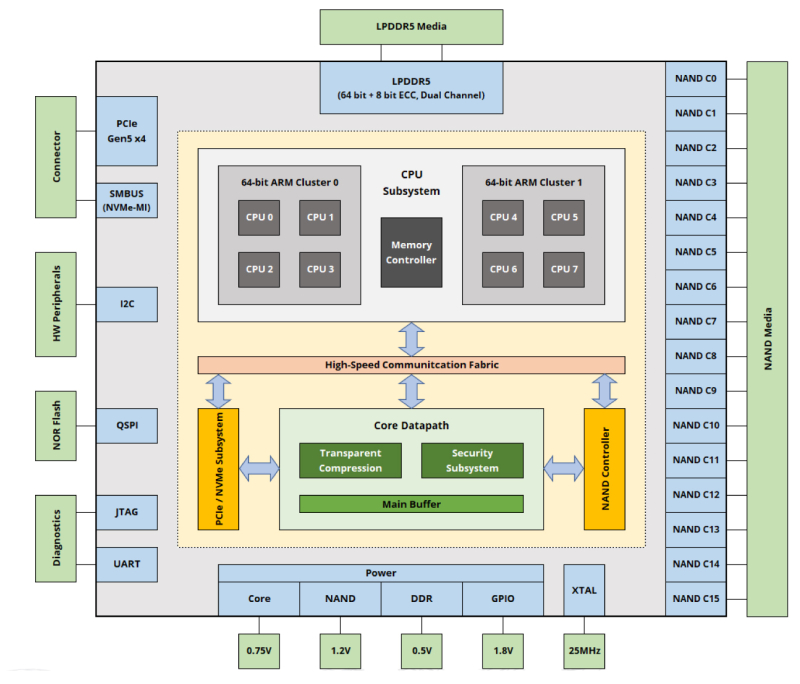

ScaleFlux представила платформу SFX 5016 для вычислительных SSD нового поколенияКомпания ScaleFlux анонсировала контроллер SFX 5016, предназначенный для создания вычислительных SSD следующего поколения. Такие устройства могут частично взять на себя нагрузку по обработке хранимых данных и тем самым высвободить ресурсы CPU для других задач. Представленное изделие соответствует спецификации NVMe 2.0 и стандарту OCP Datacenter SSD Spec 2.0. Поддерживается интерфейс PCIe 5.0. Возможно использование до 128 Гбайт памяти LPDDR5, а максимально поддерживаемая вместимость накопителей достигает 256 Тбайт (со сжатием; физически — 64 Тбайт). Контроллер обеспечивает скорость передачи информации до 14 Гбайт/с блоками по 128 Кбайт при последовательном чтении и до 11 Гбайт/с такими же блоками при последовательной записи. Заявленный показатель IOPS (операций ввода/вывода в секунду) достигает 3 200 000 при произвольном чтении данных блоками по 4 Кбайт и 1 500 000 при установившейся произвольной записи. Для контроллера SFX 5016 заявлена поддержка шифрования по алгоритму AES-256. Чип может применяться в составе накопителей с флеш-памятью NAND различных производителей, включая изделия TLC и QLC. Говорится о поддержке TCG Opal в соответствии со стандартом FIPS 140-3. Энергопотребление в активном режиме заявлено на уровне 6 Вт, в режиме простоя — менее 2 Вт. При производстве применяется 7-нм технология. ScaleFlux предлагает вычислительные накопители серий CSD 2000 и CSD 3000 на контроллерах предыдущего поколения. Так, устройства CSD 3000 используют чип SFX 3016. Контроллер SFX 5016, в свою очередь, ляжет в основу SSD серии CSD 5000.

24.02.2024 [19:16], Сергей Карасёв

Dell представила All-Flash СХД PowerScale F210 и F710 на базе Intel Xeon Sapphire RapidsКомпания Dell анонсировала СХД PowerScale F210 и F710, ориентированные на работу с неструктурированными данными. В основу устройств положены аппаратная платформа Intel и усовершенствованное ПО PowerScale OneFS 9.7. Решения выполнены в форм-факторе 1U на серверной платформе Dell PowerEdge R660. В составе модели PowerScale F210 задействован процессор Xeon Silver 4410Y поколения Sapphire Rapids, насчитывающий 12 ядер (24 потока) с максимальной тактовой частотой 3,9 ГГц (TDP — 150 Вт). Объём оперативной памяти DDR5 составляет 128 Гбайт. Возможна установка четырёх NVMe SSD вместимостью до 15,36 Тбайт каждый. Вариант PowerScale F710, в свою очередь, несёт на борту два процессора Xeon Gold 6442Y Sapphire Rapids с 24 ядрами (48 потоков) с частотой до 4,0 ГГц и TDP в 225 Вт. Объём ОЗУ равен 512 Гбайт. Имеются отсеки для десяти NVMe SSD ёмкостью до 30,72 Тбайт каждый. Обе СХД могут оснащаться двумя внешними сетевыми интерфейсами 100GbE или 25GbE, а также внутренним сетевым интерфейсом 100GbE (×2). У младшей версии общая вместимость достигает 61 Тбайт на узел и 15 Пбайт на кластер (до 252 узлов), у старшей — 307 Тбайт и 77 Пбайт соответственно. Допускается применение накопителей, основанных на флеш-чипах TLC и QLC. Отмечается, что PowerScale F210 подходит для таких задач, как ИИ и аналитика начального уровня. Модификация PowerScale F710 предназначена для генеративного ИИ и других ресурсоёмких приложений.

13.02.2024 [22:21], Алексей Степин

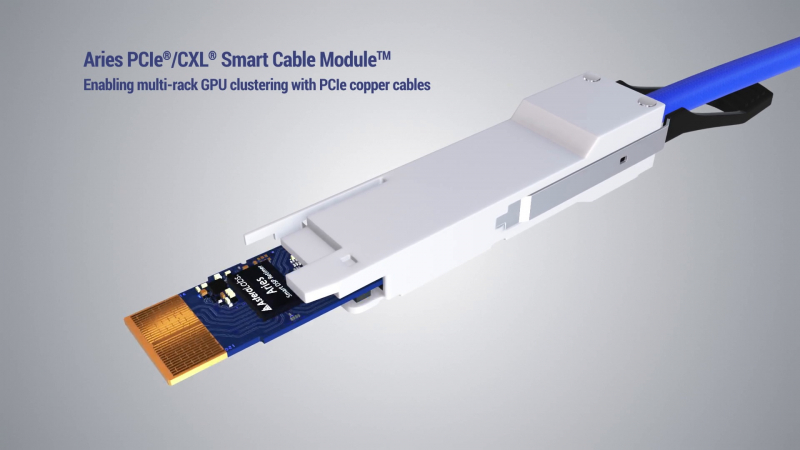

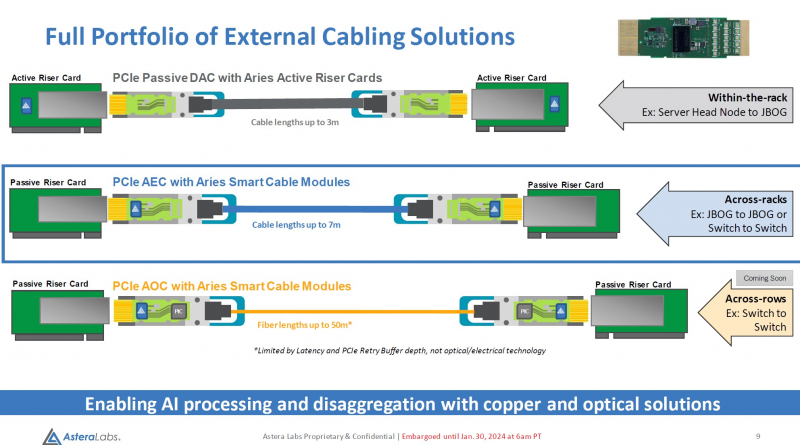

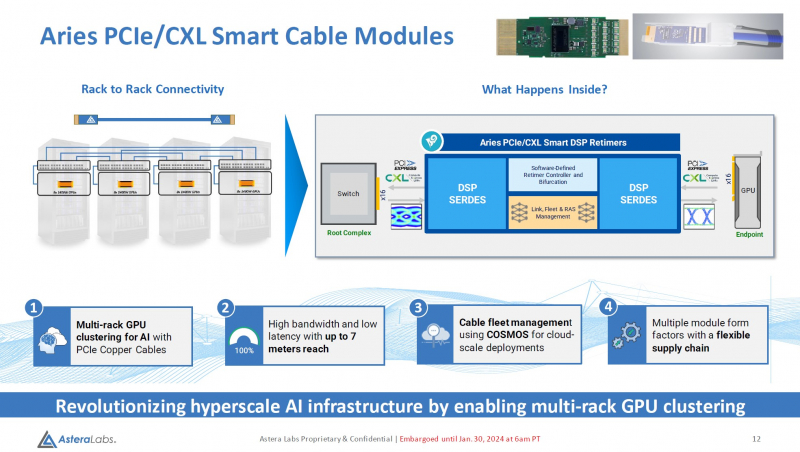

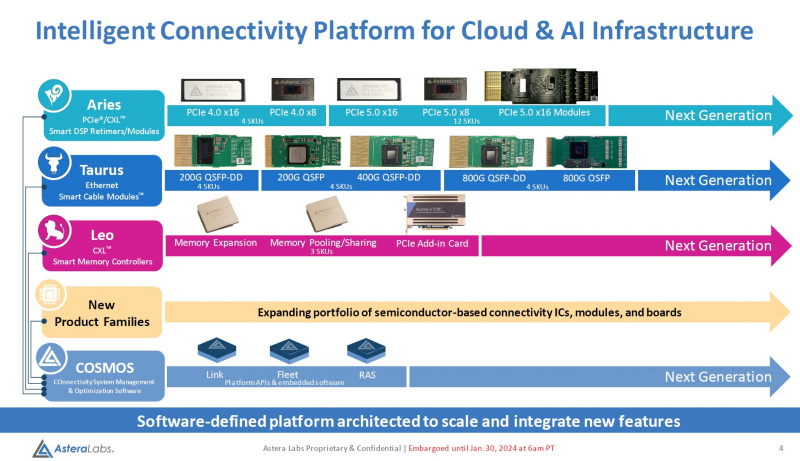

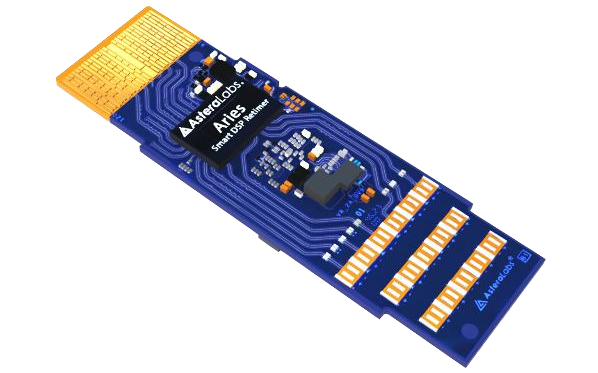

Дотянуться до GPU: Astera Labs представила кабельные модули Aries для PCIe 5.0 и CXLРазвитие пула технологий CXL естественным образом вызывает необходимость в разработке соответствующей кабельной инфраструктуры. Активные оптические кабели достаточно дороги для того, чтобы использовать их на соединениях малой длины, а полностью пассивная «медь» неизбежно потребует установки дополнительных ретаймеров. Astera Labs, разработчик решений для CXL, предлагает решить эту проблему путём использования активных медных кабелей, оснащённых встроенными ретаймерами.

Изображение: Astera Labs Новый тип кабельных модулей получил название Aries PCIe/CXL Smart Cable, он гарантирует устойчивую работу при длине соединения до 7 м, в то время как PCIe 5.0-совместимая пассивная «медь» работоспособна лишь на длинах до 3 м. В основу легли разработанные ещё в 2022 году ретаймеры серии Aries, представленные в рамках анонса целого портфолио решений с поддержкой CXL. Все решения Astera Labs поддерживают единую программно-аппаратную платформу COSMOS, отвечающую за управление и телеметрию, что должно упростить развёртывание и эксплуатацию крупномасштабных систем на базе PCIe/CXL-интерконнекта любой сложности, от комплексов GPU-кластеризации до пулов CXL-памяти. Сами ретаймеры Aries несмотря на свою компактность, представляют собой сложные устройства с достаточно производительными для работы на скоростях PCIe 5.0 сигнальными процессорами (DSP). Помимо DSP в состав чипа входит блок телеметрии и удалённого управления и программно-определяемый контроллер, отвечающий за режимы бифуркации. Применение «умных» медных кабелей Astera упростит и удешевит конструкцию систем с более чем одной стойкой, а также позволит использовать более разнообразные варианты топологии. Для подключений длиной более 7 м компания ведёт разработку активных оптических соединителей. Стоит отметить, что готовые кабели Astera Labs не продаёт. Она поставляет кабельные модули, которые гиперскейлеры и ОЕМ-производители вольны использовать в своих решениях так, как им представляется необходимым.

11.01.2024 [21:04], Сергей Карасёв

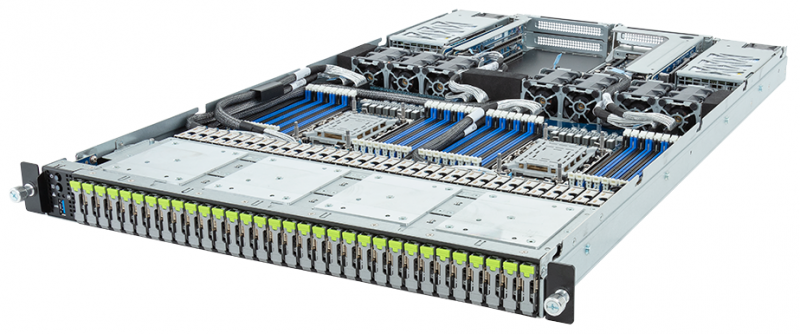

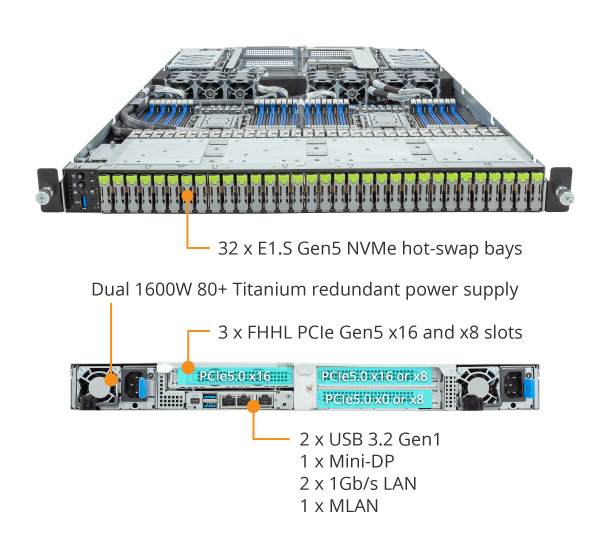

Gigabyte представила сервер хранения S183-SH0 для больших языковых моделейКомпания Gigabyte анонсировала сервер хранения S183-SH0, предназначенный, как она сама говорит, для работы с большими языковыми моделями (LLM). Новинка, выполненная в форм-факторе 1U, допускает установку двух процессоров Intel Xeon Sapphire Rapids или Emerald Rapids.

Источник изображений: Gigabyte Во фронтальной части сервера расположены 32 посадочных места для накопителей E1.S NVMe SSD с возможностью горячей замены. Это позволяет сформировать сверхбыстрое хранилище для обработки данных LLM. Кроме того, предусмотрены два коннектора для накопителей M.2 с интерфейсом PCIe 3.0 x4 или SATA 3.0. Доступны 32 слота для модулей оперативной памяти DDR5-4800/5600. Могут быть установлены три карты FHHL с интерфейсом PCIe 5.0 x16 или x8. В оснащение входит контроллер Aspeed AST2600. Есть два сетевых порта 1GbE (Intel I350-AM2) с поддержкой NCSI и выделенный сетевой порт управления. Питание обеспечивают два блока мощностью 1600 Вт с сертификатом 80 PLUS Titanium. Габариты сервера составляют 438 × 43,5 × 730 мм. Имеются три порта USB 3.2 Gen1 (один выведен на лицевую панель), интерфейс Mini-DP и гнёзда RJ-45 для сетевых кабелей. Реализована система воздушного охлаждения с семью вентиляторами диаметром 40 мм. Диапазон рабочих температур — от +10 до +35 °C.

26.11.2023 [22:48], Сергей Карасёв

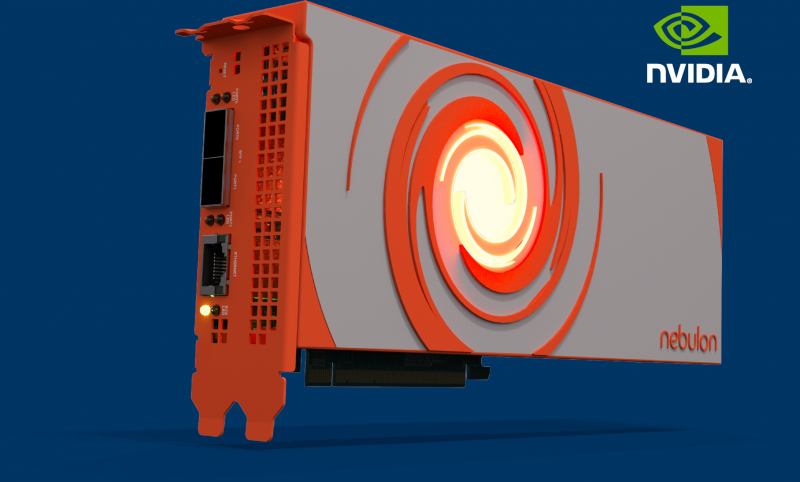

Nebulon представила ускорители Medusa2 на базе DPU NVIDIA BlueField-3Компания Nebulon анонсировала специализированные ускорители обработки сервисов (Services Processing Unit, SPU) — устройства серии Medusa2. Эти решения обеспечивают разгрузку, ускорение и изоляцию широкого спектра процессов в работе сети, СХД и подсистемы безопасности, включая обнаружение программ-вымогателей. В основу Medusa2 лёг DPU BlueField-3 разработки NVIDIA с шестнадцатью ядрами Arm Cortex-A78, тогда как первое поколение укорителей, изначально называвшихся Storage Processing Unit, было выполнено на собственной аппаратной платформе. Nebulon Medusa2 представляют собой карты расширения с интерфейсом PCIe 5.0 (х8). Они оснащены 48 Гбайт памяти DDR5 с пропускной способностью до 80 Гбайт/с. SPU подключается напрямую к внутренним накопителям NVMe (а также SAS и SATA). Ускорители оснащены двумя сетевыми портами 10/25/50/100GbE и портом управления 1GbE. SPU создает на сервере безопасную зону, отделённую от ОС и приложений — область Nebulon Secure Enclave. При этом платформа nebOS разгружает ресурсы, беря на себя выполнение таких задач, как дедупликация и сжатие данных, шифрование (AES), моментальные снимки, зеркалирование и пр. Обеспечена интеграция со средами VMware vSphere, Microsoft Server/Hyper-V и Linux/KVM. Medusa2 SPU не зависит от ОС и приложений и не требует установки каких-либо дополнительных драйверов или программных агентов. Предусмотрен криптографический сопроцессор со сверхзащищенным аппаратным хранилищем ключей и криптографическими контрмерами, которые усиливают защиту от любых потенциальных угроз, связанных с ПО. Например, обнаружение программ-вымогателей осуществляется менее чем за 2,5 мин., а на восстановление после атак таких зловредов требуется менее 4 мин. Реализованы средства безопасной загрузки. В целом, компания сравнивает свои SPU с AWS Nitro. Также анонсирован компактный ускоритель Medusa2i для edge-серверов. Он, как и старший собрат, использует DPU BlueField-3, но количество ядер Cortex-A78 уменьшено до 8, а объём памяти DDR5 — до 24 Гбайт. Возможна установка четырёх SSD формата M.2 вместимостью до 32 Тбайт каждый. Утверждается, что благодаря Medusa2 количество рабочих нагрузок на один сервер может быть увеличено на 33 %, что снижает эксплуатационные расходы и затраты на приобретение лицензий на ПО. При этом требования к мощности и площади дата-центра снижаются на 25 %. Интерес к ускорителям проявили Dell, HPE, Lenovo и Supermicro.

19.11.2023 [03:00], Сергей Карасёв

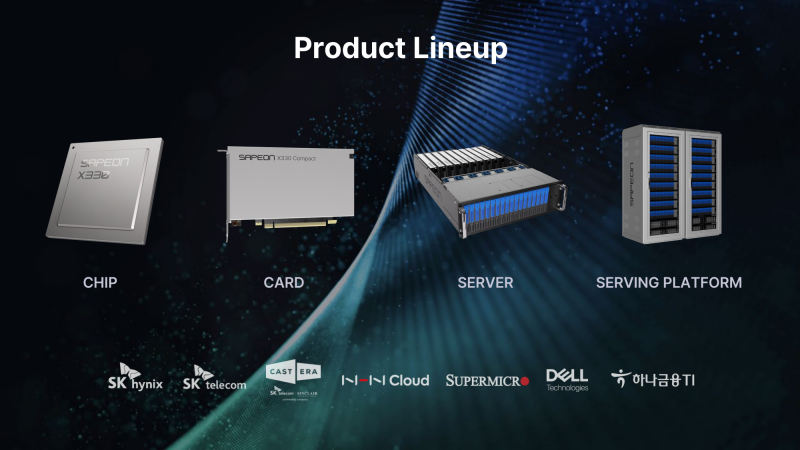

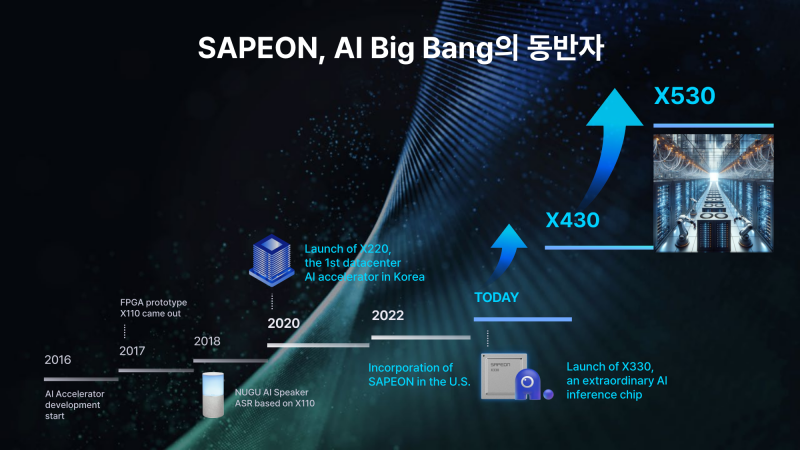

Южнокорейский стартап Sapeon представил 7-нм ИИ-чип X330ИИ-стартап Sapeon, поддерживаемый южнокорейским телекоммуникационным гигантом SK Group, анонсировал чип X330, предназначенный для инференса и обслуживания больших языковых моделей (LLM). Изделие ляжет в основу специализированных ускорителей для дата-центров. Sapeon заявляет, что новый нейропроцессор (NPU) обеспечивает примерно вдвое более высокую производительность и в 1,3 раза лучшую энергоэффективность, чем продукты конкурентов, выпущенные в этом году. По сравнению с предыдущим решением самой компании — Sapeon X220 — достигается увеличение быстродействия в четыре раза и повышение энергоэффективности в два раза. Новинка будет изготавливаться на TSMC по 7-нм технологии. Массовое производство запланировано на I полугодие 2024 года. На базе чипа будут предлагаться два ускорителя — X330 Compact Card и X330 Prime Card. Оба имеют однослотовое исполнение и оснащаются системой пассивного охлаждения. Для подключения применяется интерфейс PCIe 5.0 х16. Карты могут осуществлять вычисления INT8, FP8 и FP16. Модель X330 Compact Card уменьшенной длины несёт на борту 16 Гбайт памяти GDDR6 с пропускной способностью до 256 Гбайт/с. Заявленная производительность на операциях FP8 и FP16 достигает соответственно 367 и 184 Тфлопс. Энергопотребление варьируется в диапазоне от 75 до 120 Вт. Полноразмерная модификация X330 Prime Card получила 32 Гбайт памяти GDDR6 с пропускной способностью до 512 Гбайт/с. Заявленное быстродействие FP8 и FP16 составляет до 734 и 368 Тфлопс. Энергопотребление — 250 Вт. Группа SK в последнее время активно вкладывается в развитие ИИ, инвестируя напрямую или через дочерние структуры как в софт, так и в железо. С ней, в частности, связан ещё один южнокорейский разработчик ИИ-чипов Rebellions, также поддерживаемый правительством страны, которое намерено к 2030 году довести долю отечественных ИИ-чипов в местных дата-центрах до 80 %. Делается это для того, чтобы снизить зависимость от иностранных решений и избежать дефицита. Сама же Sapeon готовит ещё минимум два поколения своих чипов.

15.11.2023 [02:15], Владимир Мироненко

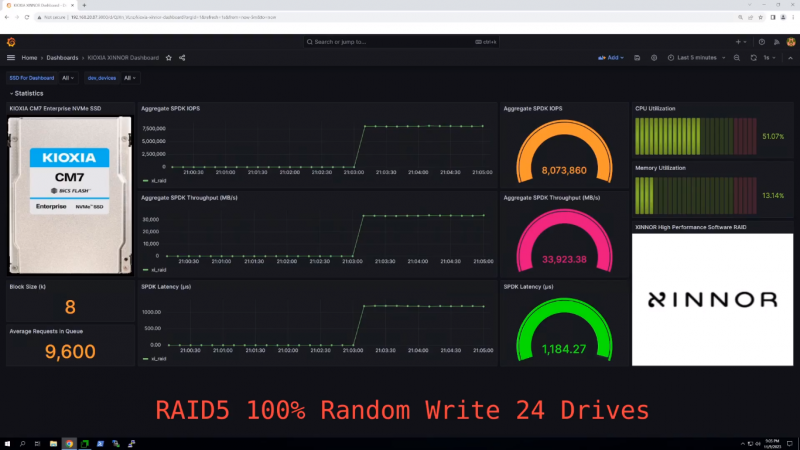

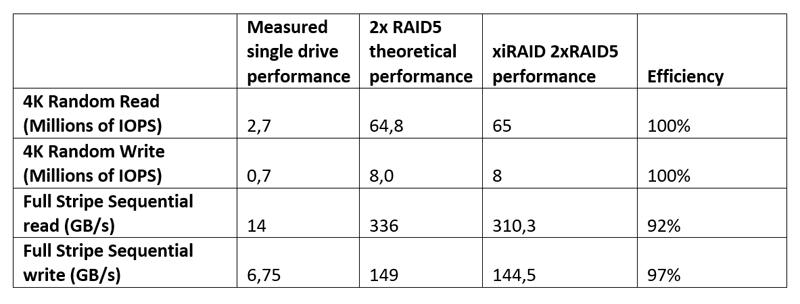

Xinnor xiRAID установил новый рекорд производительности среди NVMe-массивов с PCIe 5.0 SSD от KioxiaВ августе этого года израильская компания Xinnor, специализирующаяся на решениях для хранения данных, в том числе программного RAID для современных NVMe SSD, сообщила в ходе саммита Flash Memory Summit о мировом рекорде производительности, установленном с использованием ПО Xinnor xiRAID и 12-ти NVMe SSD Kioxia CM7-R (PCIe 5.0). На SC23 компания обновила рекорд. На этот раз в тесте были задействованы сразу 24 накопителя Kioxia CM7-V (PCIe 5.0, NVMe). Каждый диск имеет скорость последовательного чтения 14 Гбайт/с и последовательной записи 6,75 Гбайт/с, а на случайных операциях производительность составляет 2,7 млн IOPS и более 600 тыс. IOPS соответственно. При развёртывании множества таких SSD в системе первостепенное значение приобретает обеспечение надлежащей масштабируемости производительности и целостности данных. Xinnor выполнила тест на сервере Supermicro с двумя 64-ядерными процессорами AMD EPYC Genoa 9534 и 768 Гбайт RAM. Чтобы избежать узких мест, Xinnor создала две группы RAID 5 по 12 дисков так, что каждый массив находился в рамках одного NUMA-домена. Такая конфигурация обеспечивает наивысшую производительность и одновременно защиту данных в случае сбоя диска для каждого RAID, говорит Xinnor. Сообщается, что в последовательных рабочих нагрузках рекордные показатели (см. таблицу ниже) были достигнуты при использовании лишь 16 из 128 доступных ядер, а на случайных операциях xiRAID нагружал на 3–9 % лишь половину ядер. Низкая нагрузка на CPU и универсальность xiRAID, по словам компании, значительно упрощает развёртывание массивов и позволяет эффективно использовать имеющееся оборудование. Xinnor также проверила работу в деградированном режиме, когда из массива RAID 5 «выпадает» один накопитель. Даже в этом случае производительность остаётся достаточно высокой: более 34 млн и 6 млн IOPS при произвольных чтении и записи соответственно, что эквивалентно 52 % и 75 % от нормальной производительности. При последовательных операциях доступа Xinnor зафиксировала производительность выше 70 % от нормальной.  Заодно Xinnor также протестировала ту же систему, создав 2 группы RAID 6 (2 × 10 + 2). При чтении производительность была сравнима с RAID 5: 64 млн IOPS и 310 Гбайт/с. При записи производительность была ниже: 5,2 млн IOPS и 128 Гбайт/с. Впрочем, по словам Xinnor, xiRAID быстрее, чем любое другое альтернативное решение RAID. |

|